Crie

IAs

multimodelo

sem

complexida

PureRouter é um roteador de IA feito por desenvolvedores para desenvolvedores, que seleciona dinamicamente o LLM mais econômico/preciso/rápido, sem perda de desempenho

Novas contas recebem $10 dólares em créditos usando o código WELCOME10.

Crie IAs multimodelo sem complexidade

PureRouter é um roteador de IA feito por desenvolvedores para desenvolvedores, que seleciona dinamicamente o LLM mais econômico/preciso/rápido, sem perda de desempenho.

Novas contas recebem $10 dólares em créditos usando o código WELCOME10.

Selecione automaticamente os melhores LLMs com base em custo, latência e produção, economizando até 64% sem sacrificar o desempenho.

Integre em minutos com Python, teste em um ambiente de testes integrado e conecte qualquer modelo, sem restrições, sem complicações.

Da cobrança transparente ao roteamento inteligente e ao futuro suporte a modelos personalizados, o PureRouter cresce com sua infraestrutura.

Selecione automaticamente os melhores LLMs com base em custo, latência e produção, economizando até 64% sem sacrificar o desempenho.

Integre em minutos com Python, teste em um ambiente de testes integrado e conecte qualquer modelo, sem restrições, sem complicações.

Da cobrança transparente ao roteamento inteligente e ao futuro suporte a modelos personalizados, o PureRouter cresce com sua infraestrutura.

Repense como você usa LLMs

Seja para escalar sua infraestrutura de IA ou otimizar um caso de uso específico, o PureRouter permite que você faça escolhas mais inteligentes sem precisar reescrever seu código.

Repense como você usa LLMs

Seja para escalar sua infraestrutura de IA ou otimizar um caso de uso específico, o PureRouter permite que você faça escolhas mais inteligentes sem precisar reescrever seu código.

Por que escolher

o PureRouter?

Porque desenvolver com IA não deveria significar escolher entre custo, velocidade e desempenho. O PureRouter oferece a liberdade de rotear com base no que você valoriza, tudo em uma única interface intuitiva para desenvolvedores.

Por que escolher o PureRouter?

Porque desenvolver com IA não deveria significar escolher entre custo, velocidade e desempenho. O PureRouter oferece a liberdade de rotear com base no que você valoriza, tudo em uma única interface intuitiva para desenvolvedores.

Pague apenas

pelo que usar

Isso mesmo, o PureRouter funciona com um sistema de créditos, então SEM pegadinhas de assinatura e SEM cobranças surpresa.

Pague apenas

pelo que usar

Isso mesmo, o PureRouter funciona com um sistema de créditos, então SEM pegadinhas de assinatura e SEM cobranças surpresa.

Projetado para Workflows de IA Multimodelo em Escala

Deploy de Modelos Open Source, Simplificado

Nossa tela otimizada de configuração de deploy permite integração rápida de LLMs open source.

Em breve: suporte para bring-your-own-model, permitindo que você faça deploy de modelos personalizados diretamente na sua stack de roteamento.

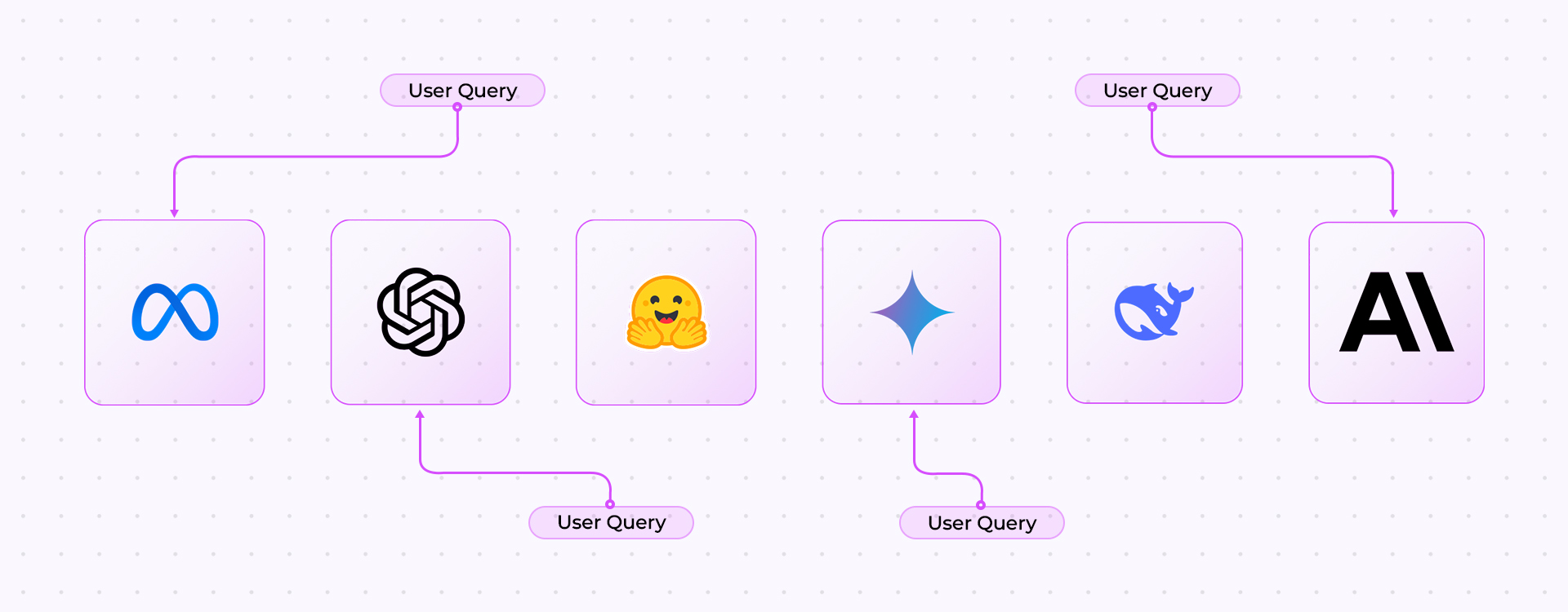

Workflows Multimodelo

Crie facilmente pipelines dinâmicos de IA selecionando entre uma lista crescente de LLMs.

Configure o roteamento entre múltiplos modelos de forma intuitiva, permitindo equilibrar custo, latência e precisão de acordo com a sua própria lógica.

Performance

que Gera Retorno

Economize entre

60% e 64%

nos custos de inferência de IA, sem comprometer a performance.

Testes em Tempo Real, Insights que Economizam para o Futuro

Teste rapidamente as solicitações em vários modelos e modos de roteamento, escolha entre velocidade, qualidade ou equilíbrio e compare instantaneamente a latência e o custo.

Em breve: previsões baseadas em uso e comparações visuais que mostram quanto você economizou com o PureRouter, incluindo estimativas mensais, tendências de desempenho e economias claras como “Você economizou R$X,XX”, acompanhadas de análises de latência e custo por modelo.

Projetado para Workflows de IA Multimodelo em Escala

Deploy de Modelos Open Source, Simplificado

Nossa tela otimizada de configuração de deploy permite integração rápida de LLMs open source.

Em breve: suporte para bring-your-own-model, permitindo que você faça deploy de modelos personalizados diretamente na sua stack de roteamento.

Workflows Multimodelo

Crie facilmente pipelines dinâmicos de IA selecionando entre uma lista crescente de LLMs.

Configure o roteamento entre múltiplos modelos de forma intuitiva, permitindo equilibrar custo, latência e precisão de acordo com a sua própria lógica.

Performance que Gera Retorno

Economize entre

60% e 64%

nos custos de inferência de IA, sem comprometer a performance.

Testes em Tempo Real, Insights que Economizam para o Futuro

Teste rapidamente as solicitações em vários modelos e modos de roteamento, escolha entre velocidade, qualidade ou equilíbrio e compare instantaneamente a latência e o custo.

Em breve: previsões baseadas em uso e comparações visuais que mostram quanto você economizou com o PureRouter, incluindo estimativas mensais, tendências de desempenho e economias claras como “Você economizou R$X,XX”, acompanhadas de análises de latência e custo por modelo.

Vários modelos

e mais a caminho...

Vários modelos

e mais a caminho...

Inicie em minutos

Sem complicações de configuração. Instale com o pip, defina suas regras de roteamento ou integre-as às existentes e conecte seus modelos.

O PureRouter foi projetado para oferecer velocidade tanto no desenvolvimento quanto na produção.

Vídeos de início rápido

Sem complicações de configuração. Instale com o pip, defina suas regras de roteamento ou integre-as às existentes e conecte seus modelos.

O PureRouter foi projetado para oferecer velocidade tanto no desenvolvimento quanto na produção.

Dúvidas? Aqui você acha as respostas

Como funciona o roteamento?

O PureRouter é uma camada de roteamento de IA. Ele recebe sua entrada e envia automaticamente para o melhor LLM disponível com base na lógica que você definir (ou nas regras padrão). Ele foi projetado para otimizar custo, desempenho ou ambos.

Posso usar meus próprios modelos?

Ainda não, mas isso já está no nosso roadmap! Em breve você poderá trazer e implantar seu próprio modelo dentro do ambiente do router.

Quais modelos são suportados hoje?

O PureRouter atualmente suporta uma ampla variedade de modelos proprietários e open-source, e estamos adicionando mais ativamente. A lista atual é:

– jamba-instruct-en

– jamba-large-en

– jamba-mini-en

– llama3.1-8b

– llama-3.3-70b

– qwen-3-32b

– command-r-plus

– command-r

– command

– command-light

– deepseek-r1-distill-llama-70b

– llama-3.3-70b-versatile

– llama-3.3-70b-specdec

– llama-guara-4-12b

– llama2-70b-4096

– llama3-8b-8192

– llama-3.2-3b-preview

– llama-3.2-11b-text-preview

– llama-3.2-90b-text-preview

– llama3-70b-8192

– llama-3.1-8b-instant

– llama-3.3-70b-versatile

– meta-llama/llama-4-scout-17b-16e-instruct

– meta-llama/llama-4-maverick-17b-128e-instruct

– mistral-saba-24b

– gemma2-9b-it

– moonshotai/kimi-k2-instruct

– Meta-Llama-3.1-8B-Instruct

– Meta-Llama-3.1-405B-Instruct

– Llama-4-Maverick-17B-128E-Instruct

– Meta-Llama-3.3-70B-Instruct

– Qwen3-32B

– DeepSeek-R1-Distill-Llama-70B

– DeepSeek-R1

– DeepSeek-V3-0324

– meta-llama/Meta-Llama-3.1-8B-Instruct-Turbo

– meta-llama/Meta-Llama-3.1-70B-Instruct-Turbo

– meta-llama/Meta-Llama-3.1-405B-Instruct-Turbo

– meta-llama/Llama-3.3-70B-Instruct-Turbo

– meta-llama/Llama-3.3-70B-Instruct-Turbo-Free

– mistralai/Mixtral-8x7B-Instruct-v0.1

– mistralai/Mistral-7B-Instruct-v0.1

– meta-llama/Llama-4-Maverick-17B-128E-Instruct-FP8

– meta-llama/Llama-4-Scout-17B-16E-Instruct

– meta-llama/Llama-3.2-3B-Instruct-Turbo

– Qwen/Qwen2.5-7B-Instruct-Turbo

– Qwen/Qwen2.5-72B-Instruct-Turbo

– deepseek-ai/DeepSeek-V3

– deepseek-ai/DeepSeek-R1

– mistralai/Mistral-Small-24B-Instruct-2501

– moonshotai/Kimi-K2-Instruct

– gpt-4-0613

– gpt-4

– gpt-3.5-turbo

– davinci-002

– babbage-002

– gpt-3.5-turbo-instruct

– gpt-3.5-turbo-instruct-0914

– gpt-4-1106-preview

– gpt-3.5-turbo-1106

– gpt-4-0125-preview

– gpt-4-turbo-preview

– gpt-3.5-turbo-0125

– gpt-4-turbo

– gpt-4-turbo-2024-04-09

– gpt-4o

– gpt-4o-2024-05-13

– gpt-4o-mini-2024-07-18

– gpt-4o-mini

– gpt-4o-2024-08-06

– gpt-4o-2024-11-20

– gpt-4o-search-preview-2025-03-11

– gpt-4o-search-preview

– gpt-4o-mini-search-preview-2025-03-11

– gpt-4o-mini-search-preview

– gpt-4.1-2025-04-14

– gpt-4.1

– gpt-4.1-mini-2025-04-14

– gpt-4.1-mini

– gpt-4.1-nano-2025-04-14

– gpt-4.1-nano

– gpt-3.5-turbo-16k

– claude-opus-4-20250514

– claude-sonnet-4-20250514

– claude-3-7-sonnet-20250219

– claude-3-5-sonnet-20241022

– claude-3-5-haiku-20241022

– claude-3-5-sonnet-20240620

– claude-3-haiku-20240307

– claude-3-opus-20240229

– deepseek-reasoner

– deepseek-chat

– deepseek-r1

– deepseek-v3

– deepseek-coder

– mistral-tiny

– mistral-small

– mistral-small-latest

– mistral-medium

– mistral-medium-latest

– mistral-medium-2505

– mistral-medium-2312

– mistral-large-latest

– mistral-large-2411

– mistral-large-2402

– mistral-large-2407

– pixtral-large-latest

– pixtral-large-2411

– pixtral-12b-2409

– open-mistral-7b

– open-mixtral-8x7b

– open-mixtral-8x22b

– codestral-latest

– codestral-2405

– open-mistral-nemo

– open-mistral-nemo-2407

– devstral-small-2505

– devstral-small-2507

– devstral-medium-2507

– magistral-medium-latest

– magistral-medium-2506

– magistral-small-latest

– magistral-small-2506

– sonar

– sonar-pro

– sonar

– sonar-pro

– sonar

– sonar

– sonar-pro

– sonar-pro

– sonar

– sonar-pro

– sonar-reasoning

– sonar-reasoning

– sonar-deep-research

– gemini-1.5-flash-latest

– gemini-1.5-flash

– gemini-1.5-flash-002

– gemini-1.5-flash-8b

– gemini-1.5-flash-8b-001

– gemini-1.5-flash-8b-latest

– gemini-2.5-flash-preview-05-20

– gemini-2.5-flash

– gemini-2.5-flash-lite-preview-06-17

– gemini-2.0-flash-exp

– gemini-2.0-flash

– gemini-2.0-flash-001

– gemini-2.0-flash-thinking-exp-01-21

– gemini-2.0-flash-thinking-exp

– gemini-2.0-flash-thinking-exp-1219

– gemma-3-1b-it

– gemma-3-4b-it

– gemma-3-12b-it

– gemma-3-27b-it

– gemma-3n-e4b-it

– gemma-3n-e2b-it

– qwen/qwen3-32b

Como os créditos são calculados?

Créditos são o nosso sistema interno de cobrança, criado para manter tudo simples e transparente.

Você pode usar créditos de duas maneiras principais:

Tempo de máquina, cada máquina (unidade de computação) possui uma taxa de créditos por hora. Quando você aloca uma máquina, os créditos são descontados com base no tempo em que ela permanece ativa

Roteamento por inferência, se você estiver apenas roteando consultas, os créditos são cobrados por chamada de modelo. Cada seleção de modelo começa em apenas 0,001 créditos por inferência, dependendo do modelo utilizado e dos tokens processados.

Durante o beta, todo novo usuário recebe US$10 em créditos gratuitos para explorar o sistema.

Sem cartão, sem assinatura, sem taxas ocultas.Assim, você pode testar tanto deploys de longa duração quanto roteamento por consulta sem se preocupar com surpresas.

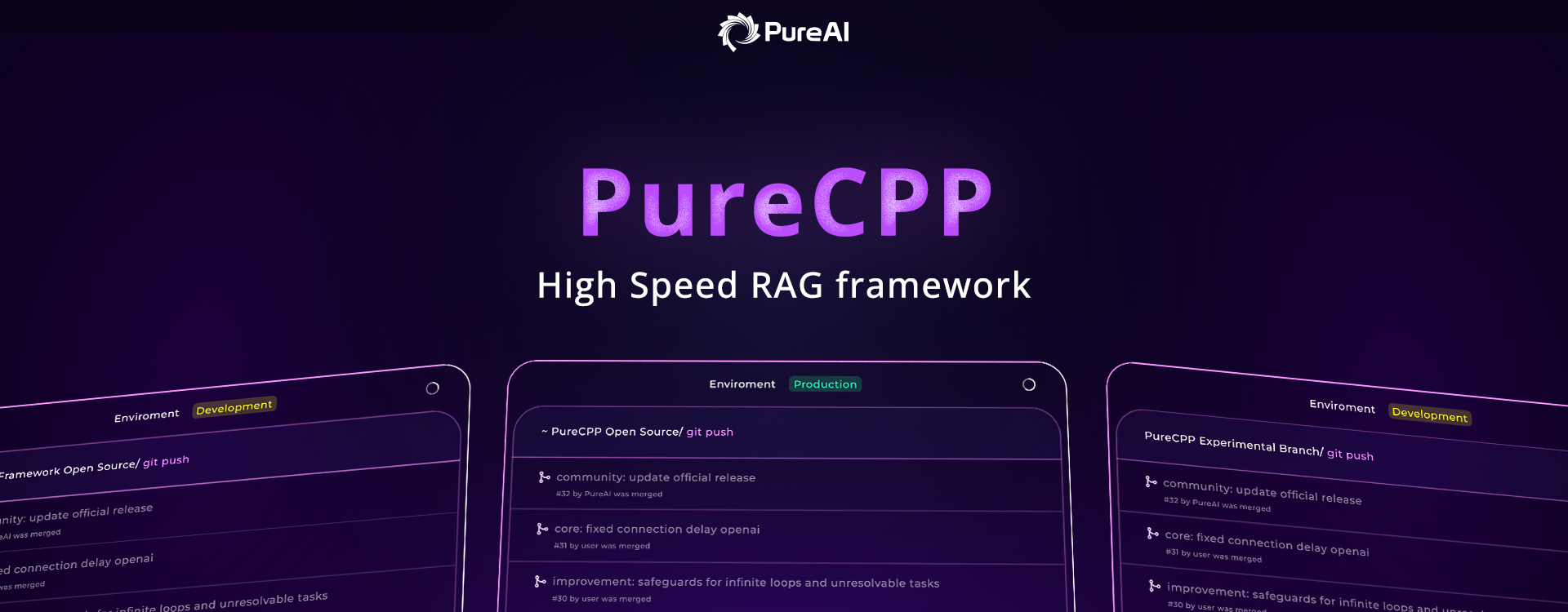

O PureRouter é open-source?

O PureRouter ainda não é open-source, mas estamos considerando modelos híbridos. O PureCPP, nossa primeira ferramenta, é totalmente open-source e será integrado perfeitamente.

Como faço o deploy em produção?

O PureRouter é preparado para produção desde o primeiro uso. Ele funciona no modelo bring-your-own-key (BYOK), permitindo que você conecte suas próprias chaves de API de provedores como OpenAI, Mistral, Cohere e outros.

No dashboard, você pode acessar a seção Access Keys, onde é possível:

- Adicionar e gerenciar suas chaves de API do PureRouter;

- Definir limites de crédito e restrições de uso para cada chave;

- Criar chaves separadas para diferentes ambientes (ex.: staging e produção) ou para usuários internos.

Essa configuração oferece total flexibilidade, controle de uso e um caminho simples e seguro para integrar o PureRouter ao seu ambiente de produção.

Últimos blogs

Fique por dentro das nossas últimas notícias, eventos e anúncios.

- AI Infrastructure, Developer Tools

- AI Infrastructure, Developer Tools, Open Source

- AI Infrastructure, Developer Tools, Machine Learning, Open Source, Technical Deep Dives